Versión en pdf.

Introducción

Las funciones diferenciables $f: \mathbb{R}^n \rightarrow \mathbb{R}^m$ son muy útiles puesto que asumimos que tienen un comportamiento infinitesimal muy simple. A secas una función diferenciable es infinitesimalmente afín (lineal más constante). Su utilidad proviene del hecho de que podemos extrapolar información de la función simple (la diferencial de $f$) al comportamiento de la función $f$ (al menos cerca del punto). Ahora queremos usar esa estrategia en una variedad abstracta.

Ya hemos definido que una función $f: M \rightarrow N$ entre variedades es diferenciable si cada una de sus representaciones coordenadas lo es. Una representación coordenada $\tilde f$ de $f$ tiene derivada en todo punto, pero ¿qué nos está diciendo la derivada $D\tilde f$, que a fin de cuentas es una representación arbitraria de $f$, acerca de $f$?

Sea $f: U \subset \mathbb{R}^n \rightarrow \mathbb{R}^m$ una función diferenciable. La siguiente proposición brinda un método útil para calcular la diferencial de $f$ en un punto $p \in U$.

Es importante notar que $\beta$ es cualquier curva que pase por $p$ y tenga a $v$ como vector tangente. La curva $\beta$ tiene a $v$ como dirección infinitesimal en $p$ y se transforma, bajo $f$, a una nueva curva $\alpha = f \circ \beta$, que tiene a $Df_p(v)$ como nueva dirección infinitesimal.

\todo{Imagen diferencial}

Es por eso que es posible pensar a la diferencial de $f$ en $p$ como la función que determina como se transforman las “direcciones infinitesimales” en $p$.

Vectores tangentes como curvas

Usando la observación anterior como pauta, haremos una generalización a variedades. Un vector tangente en $p \in M$ será una dirección infinitesimal, representada por una curva. Sin embargo varias curvas representan la misma dirección infinitesimal.

Notemos que los dominios de definición de $\alpha$ y $\beta$ no son tan relevantes, la información importante está contenida en una vecindad arbitrariamente pequeña del $0$.

\todo{imagen vector tangente}

Definimos la relación $\sim_p$ en base a la existencia de sólo una representación coordenada común para $\beta$ y $\alpha$. Sin embargo, como es usual, la relación de tener la misma dirección infinitesimal no depende de la representación coordenada elegida.

Dado que dos vectores son equivalentes si tienen la misma dirección infinitesimal (en una y por lo tanto en todas las cartas) entonces la clase de equivalencia $\left[ \alpha \right]_{\sim_p} = \left\{ \beta: I \rightarrow M \mid \beta(0) = p, \beta \sim_p \alpha \right\}$ en cierto modo representa una dirección infinitesimal, sin importar la curva que lo represente.

Cada curva que pasa por $p$ determina un vector tangente.

Definido así, la noción de vector tangente y espacio tangente no dependen de coordenadas, sino de curvas y una noción de equivalencia de dirección. Aunque la noción de equivalencia depende de modo indirecto de cartas, hemos demostrado que realmente no depende de las coordenadas elegidas. Con esta construcción hemos ganado en generalidad, pero hemos llegado a una noción un tanto abstracta e inmanejable.

Sin embargo tiene una ventaja: con esta noción de vector tangente es fácil generalizar la definición de la diferencial de una función.

\todo{imagen diferencial}

La definición anterior es una calca de la proposición. Sin embargo, en la versión clásica de la diferencial podíamos afirmar que dicha función además era lineal.

Para transferir esa proposición al caso general habría que empezar con brindarle al espacio tangente $T_pM$ una estructura de espacio vectorial. Aunque esto no es difícil, sí es un poco engorroso.

- Si $\left[ \alpha \right], \left[ \beta \right] \in T_pM$ entonces $$ \left[ \alpha \right] + \left[ \beta \right] = \left[ \varphi_{U}^{-1}\left( \bar \alpha + \bar \beta - \bar p \right) \right] $$

- Si $c \in \mathbb{R}$ y $\left[ \alpha \right] \in T_pM$ entonces $$ c \left[ \alpha \right] = \left[ \varphi_{U}^{-1}\left( c \bar \alpha - (c-1) \bar p \right) \right] $$

\todo{imagen suma de curvas}

En el apéndice demostramos que las operaciones de suma y producto por escalar están bien definidas y que con ellas $T_pM$ es un espacio vectorial.

Ya que hemos definido la estructura de espacio vectorial podemos demostrar que la diferencial es una transformación lineal.

Vectores tangentes como derivaciones

Como hemos visto, manejar a los vectores tangentes como clases de equivalencia de curvas puede llegar a ser bastante tedioso. Aunque la idea de una clase de equivalencia como representante de una dirección infinitesimal es relativamente directa, ahora hemos de dejar de lado la idea geométrica de un vector tangente como una dirección infinitesimal dada por una curva para adoptar otra visión que frecuentemente facilita el trabajo.

Comencemos en $\mathbb{R}^n$. En $\mathbb{R}^n$ toda dirección infinitesimal $\left[ \alpha \right]$ puede ser representada fielmente por su vector tangente $\alpha’(0)$. Y todo vector $v \in \mathbb{R}^n$ representa una dirección infinitesimal, puesto que define una curva $\alpha_v^p(t) = p + tv$ que lo tiene como vector tangente.

Así que en $\mathbb{R}^n$ podemos identificar los vectores tangentes con vectores en $\mathbb{R}^n$. Una modo de representar direcciones infinitesimales lo proveen las curvas, sin embargo ahora las usaremos las “derivaciones” para representarlas.

Para cada $v \in \mathbb{R}^n$ (que estamos pensando como una dirección infinitesimal en $p \in \mathbb{R}^n$) podemos definir un operador

como

Esto es $D_v^p$ es la derivada direccional en $p$, en la dirección de $v$.

- $D_v^p$ es lineal.

- $D_v^p(fg) = D_v^p(f) g(p) + f(p) D_v^p(g)$

Resulta que los operadores derivadas direccionales son buenos representantes de vectores en el siguiente sentido

Ahora que hemos visto que las derivadas direccionales sirven para representar vectores, y que además satisfacen ciertas propiedades fácilmente generalizables, no es descabellado pensar que una abstracción de este concepto podría servir para capturar la noción de espacio tangente.

Si $D$ es una derivación y $f$ es una función constante, digamos $f(p) = c$ para toda $p$, entonces $D(f) = 0$. Para ver esto podemos escribir a $f$ como $f = c \boldsymbol{1}$ donde $\boldsymbol{1}$ es la función con $\boldsymbol{1}(p) = 1$ para todo $p \in M$. Luego $D(f) = cD(\boldsymbol{1}) = c D(\boldsymbol{1}\cdot \boldsymbol{1}) = c\left( D(\boldsymbol{1}) 1 + 1 D(\boldsymbol{1}) \right) = 2c D(\boldsymbol{1})$. De aquí se sigue que $D(f) = 0$.

Las derivaciones “son” como operadores de derivada direccional, cada derivación representa derivar en una dirección. Así otro modo de definir espacio tangente en $p$ sería a través de las derivaciones $\mathscr{D}_p = T_pM$. Pero habría que justificar dicha afirmación, puesto que ya tenemos otra noción de vector tangente.

En primero lugar observemos que

Como en el caso de curvas diferenciales como vectores tangentes, es relativamente fácil definir la derivada de una función en términos de derivaciones.

Regresamos a la demostración de la afirmación de que la noción de vector tangente con curvas es compatible y equivalente a la dada por derivaciones.

Con esto hemos terminado de demostrar que podemos pensar a cualquier vector tangente de dos modos, como una derivación o como una familia de curvas que apuntan en la misma dirección infinitesimal. El uso de una u otra visión es cuestión de conveniencia.

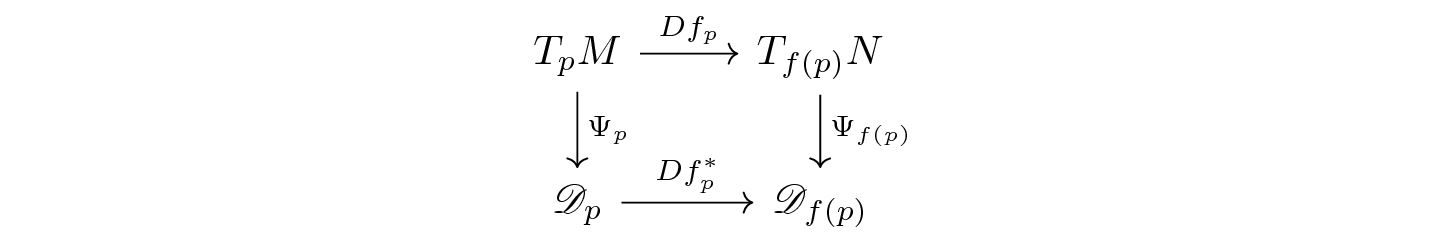

Definimos dos versiones diferentes de la diferencial de una función $f: M \rightarrow N$: una que depende de la noción de curvas y otra de la noción de derivaciones. La siguiente proposición afirma que las dos nociones coinciden cuando se usa el isomorfismo $\Psi_p$ para traducir una versión de vector tangente a la otra.

conmuta.

conmuta.

De ahora en adelante todo vector $v \in T_pM$ será, al mismo tiempo, una clase de equivalencia de curvas que pasan por $p$ y tienen la misma dirección infinitesimal y una derivación en $p$. Así si $v= \left[ \alpha \right]$ y $f \in C^{\infty}(M)$ entonces

Estamos escondiendo a $\Psi_p$ para aliviar la notación.

Representaciones coordenadas

Ahora que definimos correctamente la noción de un vector tangente en una variedad abstracta daremos una descripción de los vectores tangentes en términos de coordenadas. Así que fijemos una carta $(U, \varphi_U)$ con la cual poner coordenadas en los puntos de $U$.

Tomemos $p \in M$ y sea, como es usual, $\bar p = \varphi_U(p)$. Cada curva $\alpha: I \rightarrow M$ que pasa por $p$, es decir $\alpha(0) = p$, tiene una representación coordenada $\bar \alpha = \varphi_U \circ \alpha$ que pasa por $\bar p$ en $0$. Esta curva tiene un vector tangente en $\bar p$, el cual representa la dirección infinitesimal de $\bar \alpha$ en $\bar p$. Esta receta define un mapeo

definido por

que a cada vector tangente le da su representación coordenada.

La demostración anterior también nos da el isomorfismo inverso:

En particular, para cada punto de $U$, la representación coordenada induce una base de $T_pM$, llamada la base canónica inducida por la carta $(U,\varphi_U)$, dada por $\left\{ \Upsilon_p^{-1}(e_i)\right\} $, donde $\left\{ e_1,\cdots,e_n \right\}$ es la base canónica de $\mathbb{R}^n$. A estos vectores se les denota por

\todo{imagen vectores canónicos}

Si el punto $p \in M$ es claro del contexto, entonces escribiremos simplemente $\partial x_i$. Es común encontrarlos en la literatura como $\partial x_i = \partial_i = \frac{\partial}{\partial x_i}$.

Todo vector $\left[ \alpha \right] \in T_pM$ puede expresarse en términos de esta base:

Aplicando $\Upsilon_p$ a ambos lados de la ecuación se obtiene

por lo que $(a^1,\cdots,a^n) = \bar \alpha’(0)$. Entonces

En términos de derivaciones podemos decir lo siguiente:

De aquí que al vector $\partial x_i$ también se le llame $\frac{\partial}{\partial x_i}$.

Así si $v$ es cualquier vector $T_pM$ entonces podemos escribir

y luego

Ahora estudiaremos la representación coordenada de la diferencial de una función. Sea $f:M \rightarrow N$ una función diferenciable, $p \in M$, $(U, \varphi_U)$ una carta alrededor de $p$ y $(V, \varphi_V)$ una carta alrededor de $f(p)$, donde $M$ es una variedad m-dimensional y $N$ es una variedad n-dimensional. Con estas cartas podemos dar una descripción coordenada de $f$, dada por $\tilde f = \varphi_V \circ f \circ \varphi_U^{-1}$. Digamos que $\bar \delta$ denota la representación coordenada de $\delta$ con la carta $(U, \varphi_U)$ y $\hat \gamma$ denota la representación coordenada de $\gamma$ con la carta $(V,\varphi_U)$. Las cartas inducen bases

de los espacios tangentes $T_pM$ y $T_{f(p)}N$, respectivamente. Queremos estudiar el mapeo $Df_p: T_pM \rightarrow T_{f(p)}N$ en términos de estas bases.

En otras palabras la matriz de la diferencial $Df_p$ es la matriz jacobiana de la representación coordenada $\tilde f$ en el sentido clásico.

Apéndices

El espacio tangente (curvas) es un espacio vectorial

- El espacio tangente tiene un cero $0 \in T_pM$. Definimos el $0$ en $T_pM$ como la clase de la curva $0_p: \mathbb{R} \rightarrow M$ dada por $0_p(t) = p$. Dicha curva es diferenciable y satisface $0_p(0) = p$, por lo que define un vector tangente $[0_p] = 0$. Sea $\alpha: I \rightarrow M$ cualquier otra curva diferenciable con $\alpha(0) = p$. Queremos demostrar que $$ [\alpha] + 0 = \left[ \alpha \right] $$ Para esto hay que tomar una carta $(U,\varphi_U)$ y demostrar que $$ \left[ \alpha \right] + 0 = [\varphi_U^{-1}( \varphi_U \circ \alpha + \varphi_U \circ 0_p - \varphi_U(p))] = \left[ \alpha \right] $$ es decir si $\beta = \varphi_U^{-1}\left( \varphi_U \circ \alpha + \varphi_U \circ 0_p - \varphi_U(p) \right)$ entonces que $$ \beta \sim_p \alpha $$ De nuevo esto requiere demostrar que los vectores tangentes de alguna representación coordenada son iguales en $0$, y para esto tomaremos la misma carta $\left( U, \varphi_U \right)$ para representar a las curvas. $$ \bar \beta = \varphi_U \left( \varphi_{U}^{-1}\left( \bar \alpha + \bar 0_p - \varphi_U(p) \right) \right) = \bar \alpha + \varphi_U(0_p) - \varphi_U(p) = \bar \alpha $$ puesto que $\varphi_U(0_p(t))=p$ para todo $t \in \mathbb{R}$. Luego $\bar \beta'(0) = \bar \alpha'(0)$ y $\beta \sim_p \alpha$ y por lo tanto $\left[ \alpha \right] + 0_p = \left[ \alpha \right]$.

- Demostrar que todo vector tiene inverso aditivo: Sea $\left[ \alpha \right] \in T_pM$ un vector. Su representante es una curva diferenciable $\alpha: I \rightarrow M$ con $\alpha(0) = p$. Sea $\beta: I' \rightarrow M$ la curva definida por $\beta(t) = \alpha(-t)$. Dicha curva satisface $\beta(0) = \alpha(0) = p$ y es diferenciable. Afirmamos que $$ [\alpha] + [\beta] = 0 $$ De nuevo sea $(U,\varphi_U)$ cualquier carta alrededor de $p$, por lo que la suma $\left[ \alpha \right] + \left[ \beta \right]$ es la clase de equivalencia representada por la curva $$ \gamma = \varphi_U^{-1}\left( \bar \alpha + \bar \beta - \bar p \right) $$ Demostrar que $\left[ \alpha \right] + \left[ \beta \right] = 0$ es equivalente a demostrar que $\gamma \sim_p 0_p$. Con la misma carta $(U,\varphi_U)$, la representación coordenada de $\gamma$ bajo $\varphi_U$ es: $$ \bar \gamma = \bar \alpha + \bar \beta - \bar p $$ Notemos que $\bar \beta(t) = \varphi_U(\beta(t)) = \varphi_U(\alpha(-t)) = \bar \alpha(-t)$ y por lo tanto $\bar \beta'(0) = - \bar \alpha'(0)$, así $$ \bar \gamma'(0) = 0 = \bar 0_p'(0) $$ Luego $\gamma \sim_p 0_p$ y $[\alpha] + \left[ \beta \right] = 0$.

- Por último demostraremos que la multiplicación por escalares es distributiva. Sean $\left[ \alpha \right],\left[ \beta \right] \in T_pM$ y $c \in \mathbb{R}$. Queremos demostrar que $$ c\left( [\alpha] + \left[ \beta \right] \right) = c\left[ \alpha \right] + c\left[ \beta \right] $$ Sea $(U, \varphi_U)$ una carta alrededor de $p$. Luego las curvas $\left[ \alpha \right] + \left[ \beta \right]$, $c\left[ \alpha \right]$ y $c\left[ \beta \right]$ están representadas por $$ \left[ \alpha \right] + \left[ \beta \right] = \left[ \varphi_U^{-1}\left( \bar \alpha + \bar \beta - \bar p\right) \right] = \left[ \gamma \right] \\ c\left[ \alpha \right] = \left[ \varphi_U^{-1}\left( c \bar \alpha - (c-1) \bar p \right) \right] = \left[ \nu_1 \right] \\ c\left[ \beta \right] = \left[ \varphi_U^{-1}\left( c \bar \beta - (c-1) \bar p\right) \right] = \left[ \nu_2 \right] $$ Y por lo tanto las curvas $c\left( \left[ \alpha \right] + \left[ \beta \right] \right)$ y $c\left[ \alpha \right] + c\left[ \beta \right]$ están representadas por $$ c\left( \left[ \alpha \right] + \left[ \beta \right] \right) = c\left[ \gamma \right] = \left[ \varphi_{U}^{-1}\left( c \bar \gamma - (c-1)\bar p\right) \right] = \left[ \tau_1 \right] \\ c\left[ \alpha \right] + c\left[ \beta \right] = \left[ \nu_1 \right] + \left[ \nu_2 \right] = \left[ \varphi_U^{-1}\left( \bar \nu_1 + \bar \nu_2 - \bar p\right) \right] = \left[ \tau_2 \right] $$ Queremos demostrar que $\left[ \tau_1 \right] = \left[ \tau_2 \right]$, es decir $\tau_1 \sim_p \tau_2$. Para esto tomamos la misma carta $(U, \varphi_U)$ para representar con coordenadas a las curvas $\tau_i$. Noten que, por la definición de $\gamma$, $$ \begin{aligned} \bar \tau_1 &= c \varphi_U \circ \gamma - (c-1)\bar p\\ &= c \varphi_U \circ \varphi_U^{-1}\left( \bar \alpha + \bar \beta - \bar p\right) - (c-1)\bar p\\ &= c \bar \alpha + c \bar \beta -(2c-1)\bar p \end{aligned} $$ y, por las definiciones de $\nu_i$, $$ \begin{aligned} \bar \tau_2 &= \varphi_U \circ \nu_1 + \varphi_U \circ \nu_2 - \bar p \\ & =\varphi_U \circ \varphi_U^{-1}\left( c \bar \alpha - (c-1) \bar p \right) + \varphi_U \circ \varphi_U^{-1}\left( c \bar \beta - (c-1)\bar p \right) - \bar p\\ & = c \bar \alpha + c \bar \beta - 2(c-1) \bar p- \bar p\\ & = c \bar \alpha + c \bar \beta - (2c - 1)\bar p \end{aligned} $$ Luego $\bar \tau_1 = \bar \tau_2$, en particular $\bar \tau_1'(0) = \bar \tau_2'(0)$. Así $\tau_1 \sim_p \tau_2$ y por lo tanto $c(\left[ \alpha \right] + \left[ \beta \right]) = c\left[ \alpha \right] + c\left[ \beta \right]$.

Las funciones diferenciables de una variedad

En $\mathbb{R}^n$ existen diversas maneras de definir funciones apropiadas para diversas tareas. Sin embargo puede ser que nos encontremos muy limitados al tratar de encontrar funciones diferenciables en una variedad abstracta $M$.

Un método para definir funciones en $M$ podría ser como sigue: Tomen una carta $(U, \varphi_U)$ y usen las coordenadas para definir funciones en $U$. O dicho de otro modo si $f: \varphi_U \subset \mathbb{R}^n \rightarrow \mathbb{R}$ es cualquier función diferenciable entonces $\hat f = \varphi_U \circ f$ es una función diferenciable en $U$. Sin embargo esta receta sólo produce una función en $U$ que posiblemente sea difícil (si no es que imposible) extender diferenciablemente a una función en todo $M$.

Este problema es resuelto, parcialmente, por las funciones chipote.

- $h(x) = 1$ para todo $x \in U$.

- $h(x) = 0$ para todo $x \notin V$.

- $h(x) \geq 0$ para todo $x \in \mathbb{R}^n$.

Un resultado importante de la topología diferencial es el hecho de que siempre existen funciones chipote para cualquier par de abiertos $U \subset V \subset \mathbb{R}^n$ con $\overline{U} \subset V$. La demostración de este hecho está en las notas de particiones de la unidad. Así que, de ahora en adelante, simplemente vamos a aceptar la existencia de dichas funciones.

Estas funciones chipote nos ayudarán a extender funciones definidas localmente (en coordenadas) a toda la variedad.

Supongamos que estamos en una carta $(U,\varphi_U)$ y hemos elegido una función particular $f: \varphi_U(U) \rightarrow \mathbb{R}$ por que su comportamiento nos es favorable cerca del punto $x \in U$. Puesto que $U$ es un abierto existen $\varepsilon_1 < \varepsilon_2 < \varepsilon_3$ tales que $B_{\varepsilon_3}(x) \subset U$ y para los cuales podemos encontrar una función chipote $h$ para el par $(B_{\varepsilon_1}(x),B_{\varepsilon}(x))$. Notemos que la función $h$ es cero en una vecindad abierta de la frontera $\partial \varphi_U(U)$ (a saber $\mathbb{R}^n \setminus \overline{B_{\varepsilon_2}(x)}$) y $h=1$ en una vecindad de $x$. Luego la función $\tilde f = fh$ es una función definida en $\varphi_U(U)$ tal que $\tilde f = f$ en una vecindad abierta de $x$ y $\tilde f = 0$ en una vecindad abierta de $\partial \varphi_U(U)$. Luego si definimos $k: M \rightarrow \mathbb{R}$

entonces resulta que $k$ es una función diferenciable de $M$ cuya representación coordenada en la carta $(U, \varphi_U)$ satisface $\bar k = f$ en una vecindad de $x$.

De este modo uno puede crear variedad de funciones con el comportamiento local que uno desee.